2025年(50)

分类: IT业界

2025-03-18 18:15:38

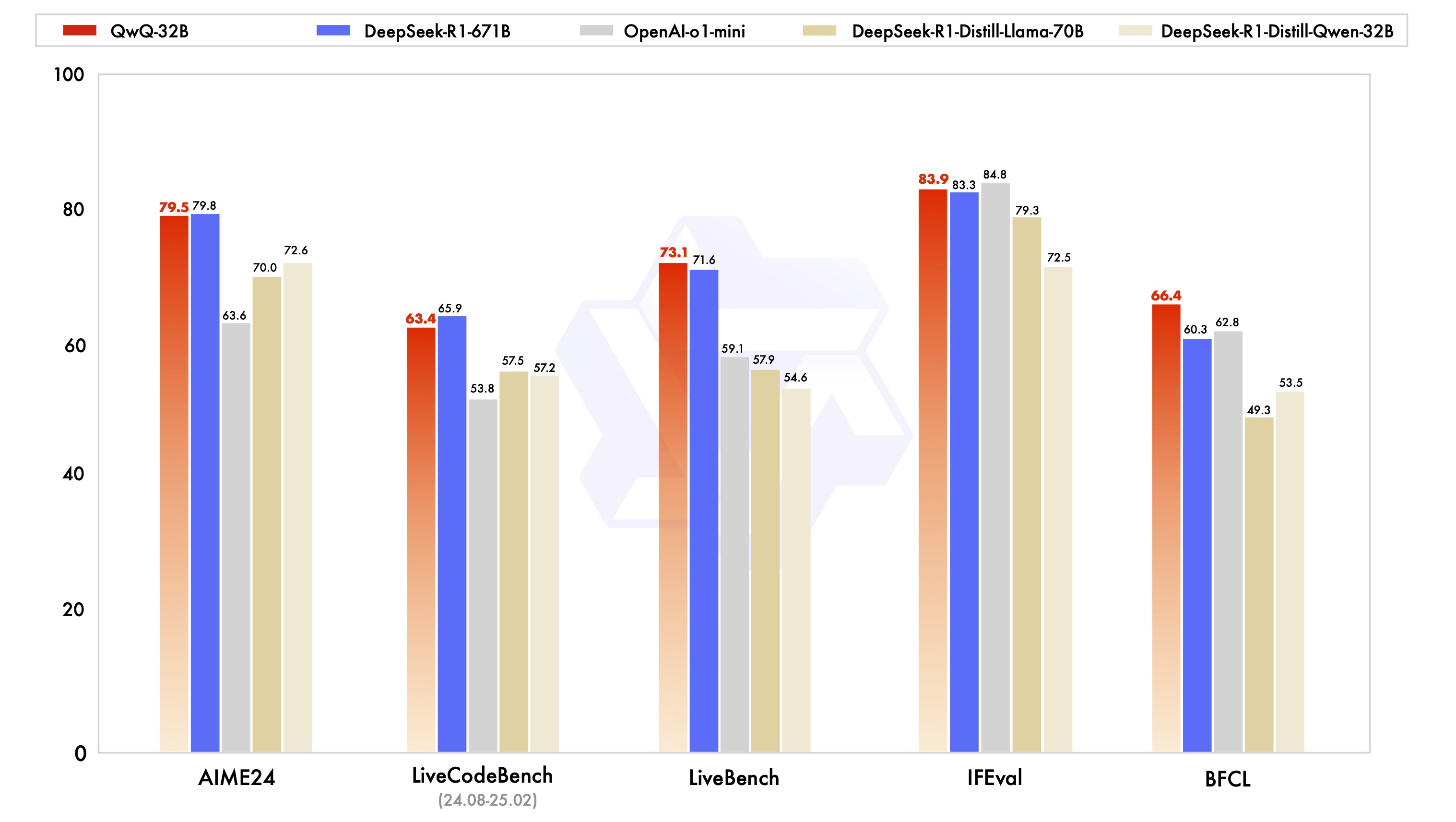

此存储库包含 QwQ 32B 模型 ,该模型具有以下特点:

curl -fsSL | sh

设置模型下载地址、开放 ip 及端口:

(可选)如有模型地址更改需求,可用下命令:

export OLLAMA_MODELS=/root/sj-tmp/ollama/models

设置 ip 地址及端口:

export OLLAMA_HOST=0.0.0.0:8080

然后记得通过 vim /root/.bashrc 写入文件

直接运行:

ollama serve

等待运行成功后,可以在另一个终端通过 api 访问:

curl

持久运行(后台模式)

如果你需要 ollama 在后台运行,可以使用:

nohup ollama serve > ollama.log 2>&1 &

或者使用 tmux / screen 来保持会话。

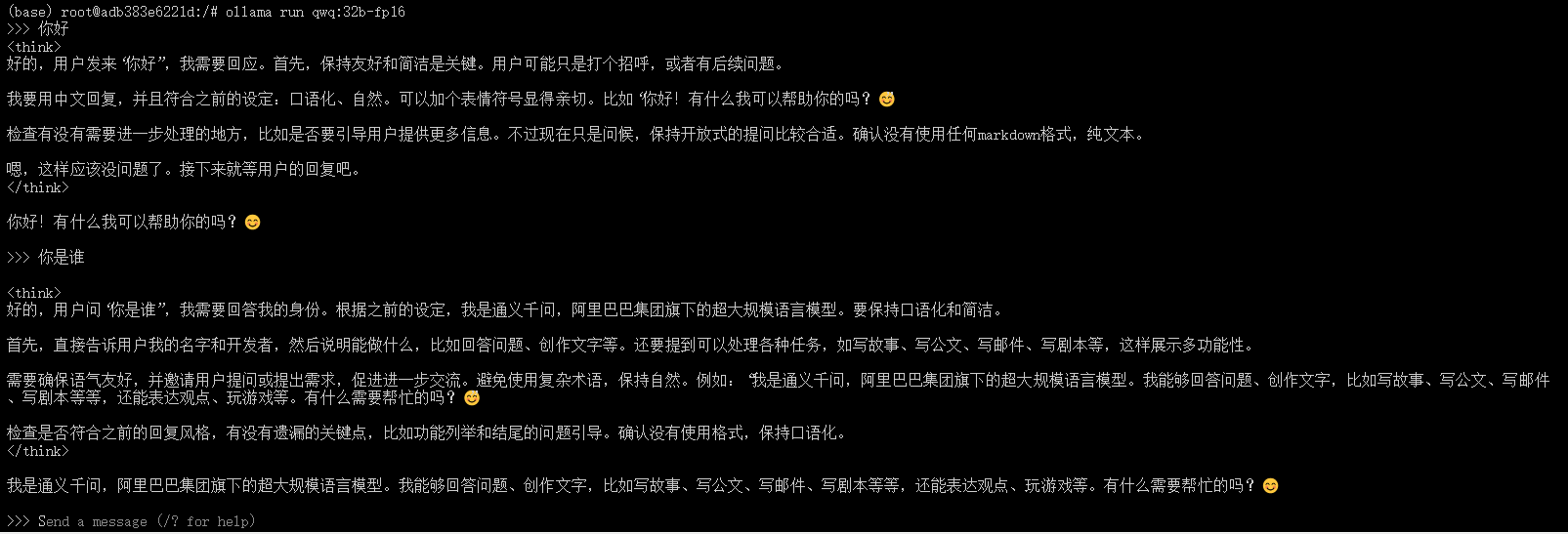

ollama run qwq:32b-fp16

等待下载完成后,可以直接进行对话:

可以使用 PowerShell 或 Python 访问它。

? PowerShell

如果你想在 PowerShell 里 调用 ollama run qwq:32b-fp16 进行推理 :

Invoke-RestMethod -Uri "" -Method Post -Body (@{model="ollama run qwq:32b-fp16"; prompt="你好,介绍一下自己"} | ConvertTo-Json -Depth 10) -ContentType "application/json"

? Python

如果你想在 Python 里调用 :

import requests

import json

url = ""

data = {

"model": "qwq:32b-fp16",

"prompt": "在数学中,3.11 和 3.8 谁大?请给出详细分析。",

}

response = requests.post(url, json=data)

# 存储{BANNED}最佳终的文本结果

text_output = ""

# 逐行解析 JSON

for line in response.text.strip().split("\n"):

try:

json_data = json.loads(line) # 解析每一行 JSON

if "response" in json_data:

text_output += json_data["response"] # 拼接文本

if json_data.get("done", False): # 检查是否完成

break

except json.JSONDecodeError as e:

print("JSON 解析错误:", e)

print("{BANNED}最佳终结果:", text_output)

通过 Python pip 安装

Open WebUI 可以使用 Python 包安装程序 pip 进行安装。在继续之前,请确保您使用的是 Python 3.11 以避免兼容性问题。

(1)安装 Open WebUI: 打开终端并运行以下命令以安装 Open WebUI:

pip install open-webui

运行 Open WebUI: 安装后,您可以通过执行以下命令来启动 Open WebUI:

open-webui serve

等待服务启动之后,可以看到出现 0.0.0.0:8080 的地址,这时我们只需在平台开放端口即可进行访问 open webui 界面

{BANNED}中国第一次使用需要进行注册账号:

首次登录需要等待一会儿,进入以后界面如下:

注:如果忘记账号密码导致无法登入界面,可以删除账号信息,选择重新注册:

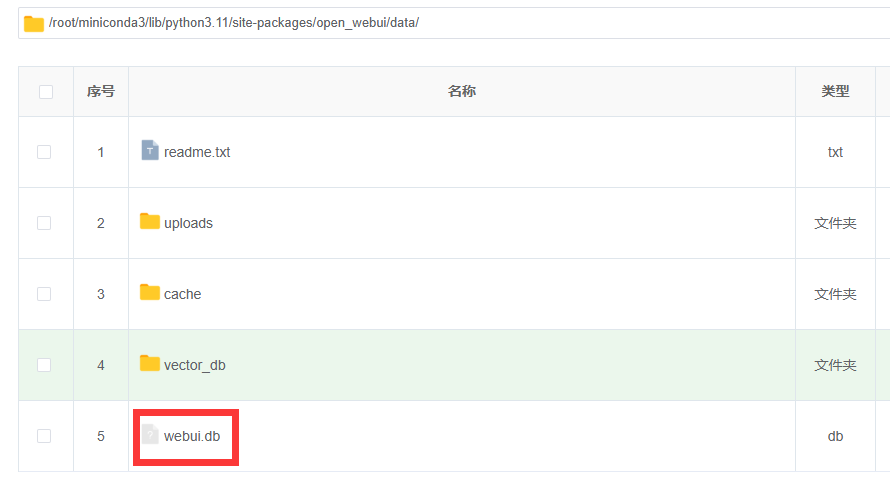

(1)点击文件管理,输入 /root/miniconda3/lib/python3.11/site-packages/open_webui/data/ 的路径并进入

(2)删除下面 webui.db 这个文件,然后重新启动即可

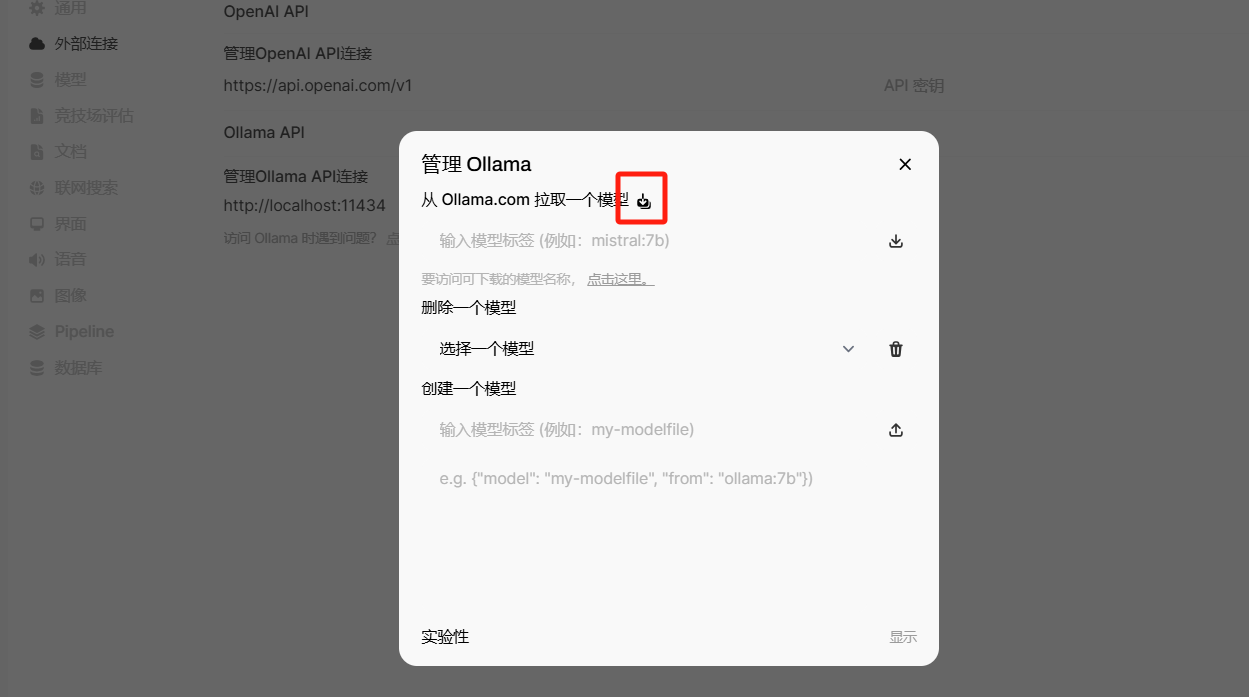

正常情况下,进入 open webui 界面中就能自动获取模型,如果没有可以按照下面操作进行:

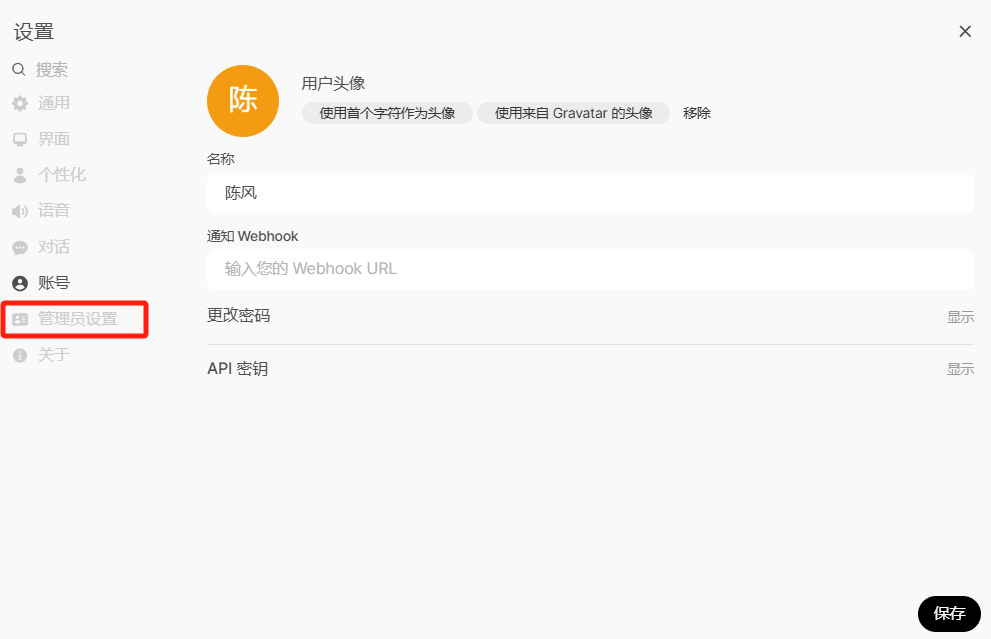

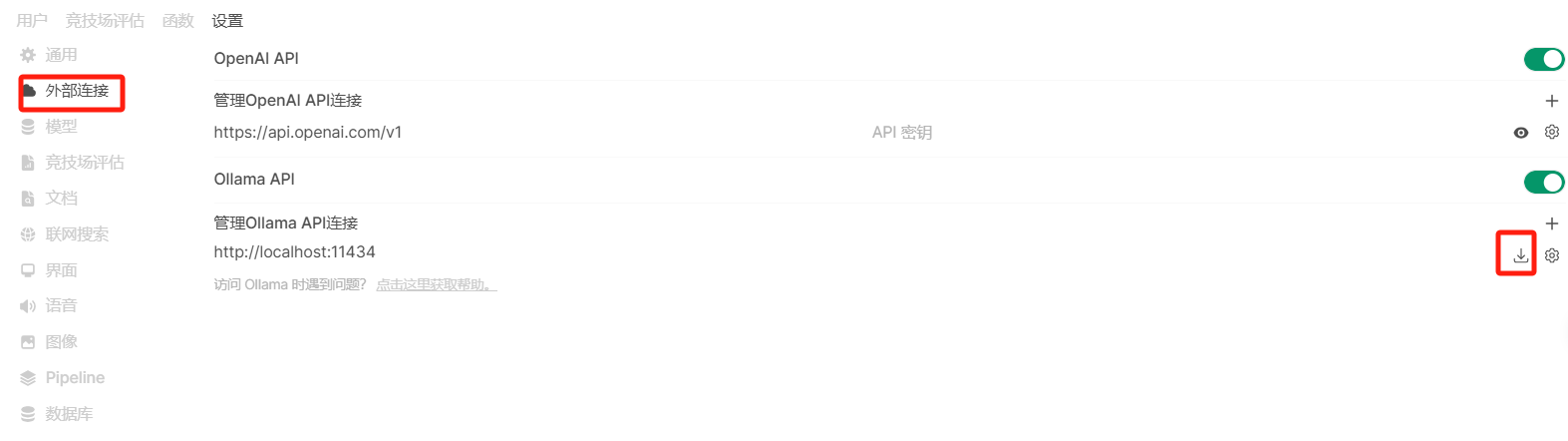

要在 Open WebUI 中管理您的 Ollama 实例,请执行以下步骤:

管理屏幕如下所示:

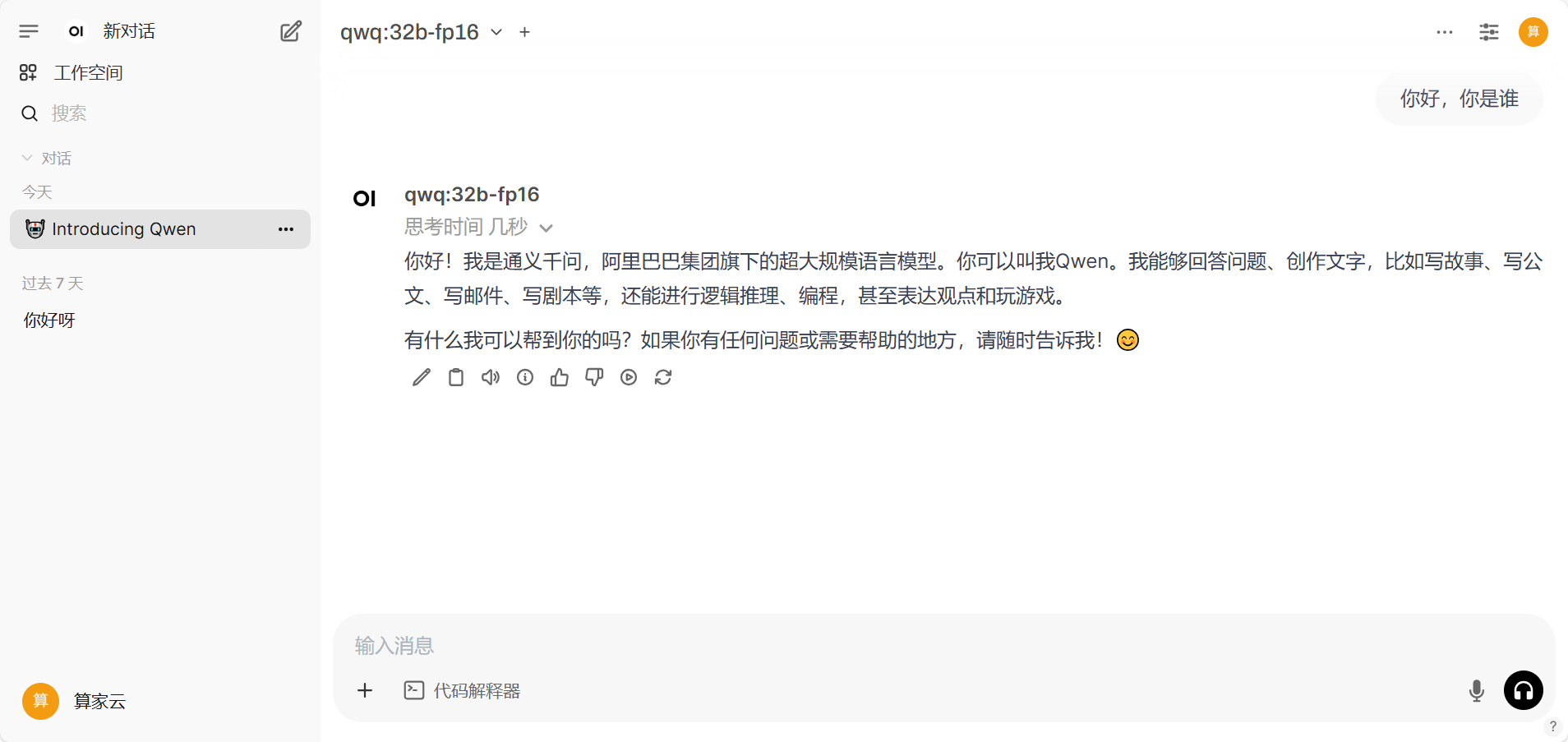

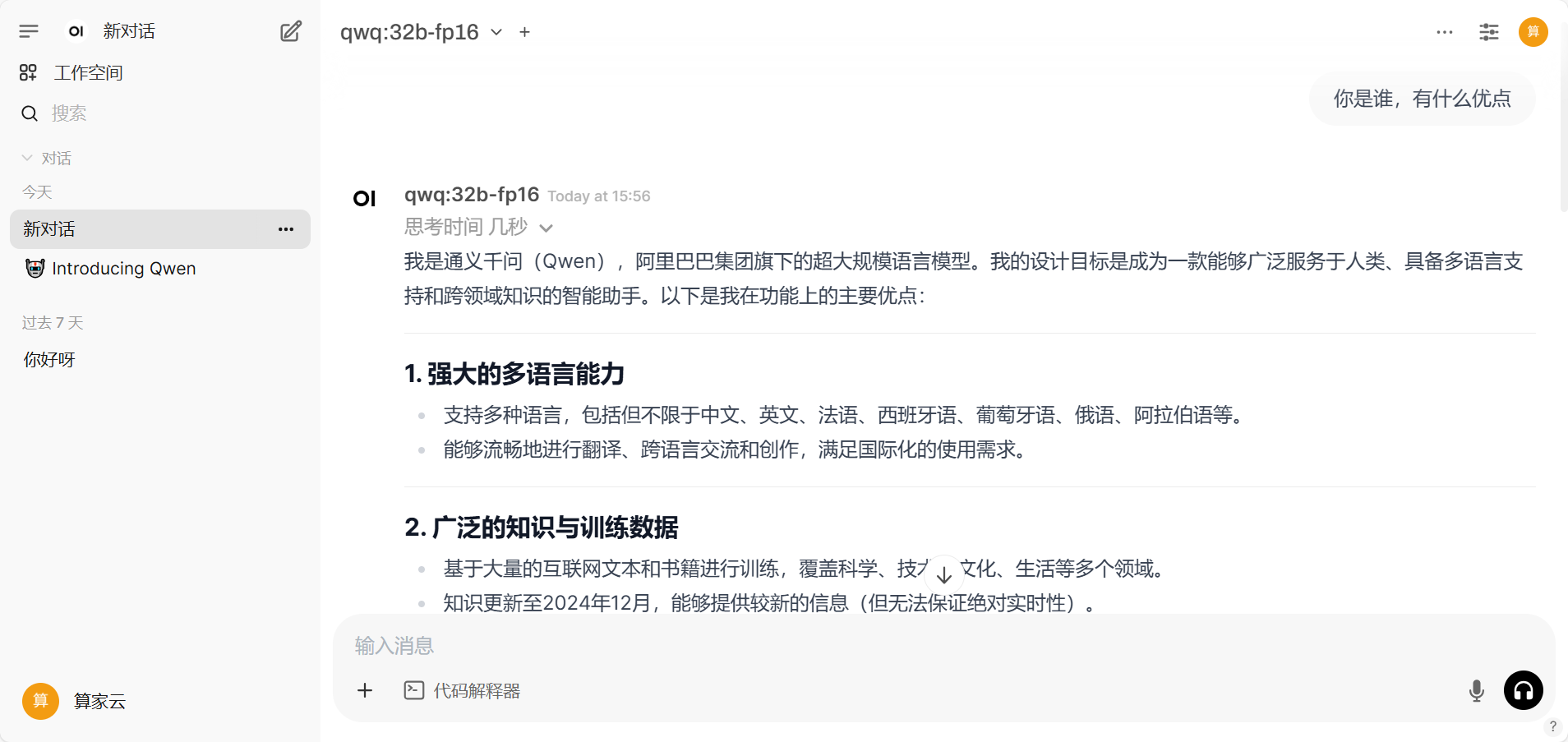

然后返回对话界面即可进行对话:

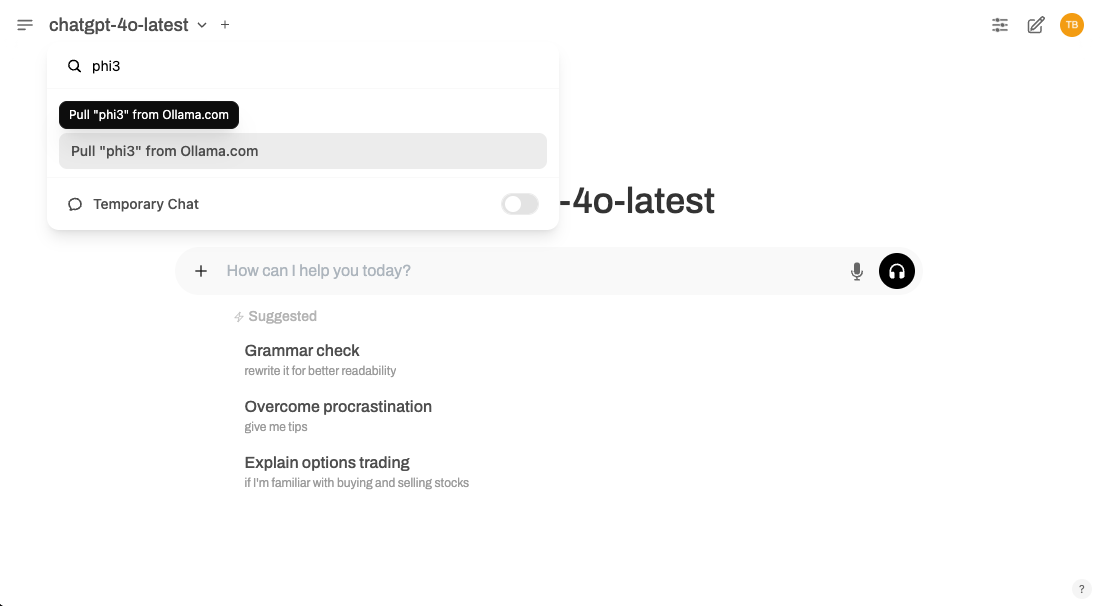

可以直接从 Model Selector 下载模型。只需输入想要的模型的名称,如果它还不可用,Open WebUI 将提示从 Ollama 下载它。

下面是一个工作原理示例:

如果想跳过 Admin Settings 菜单的导航,直接使用的模型,则此方法非常理想。