相对于物理磁带库,虚拟磁带库(VTL:Virtual Tape Library)使用了兼容磁带备份管理软件和传统备份作业流程,既可以保存用户对物理磁带库的已有投资,又可以通过使用更可靠、更稳定的磁盘代替磁带存储介质,使设备可用性和备份可靠性大幅提升。如果归档数据未被导出到物理磁带,而是存于VTL系统的磁盘之中,要恢复它也不会涉及任何机械工作,速度就像磁盘备份一样,恢复工作得以极大简化。VTL的上述优点,使得VTL在替代老的备份系统和新建备份系统中大受欢迎,得到广泛的市场和用户认可。

伴随VTL市场的发展,各种新的优化技术应运而生。本文主要针对VTL设备中的容量优化技术,包括硬件压缩(Hardware Compression)和重复数据删除(De-Duplication)技术进行初步探讨。

硬件压缩

存储系统通过使用RAID加速卡和TCP/IP卸载引擎加速卡(TOE:TCP Offload Engine),可以显著提升系统RAID计算以及TCP/IP协议的性能。类似地,通过采用专门的硬件压缩加速卡,将原来运行于VTL系统主机CPU上的压缩/解压缩任务,转交到单独的硬件/解压缩压缩加速卡上,可以显著提升VTL系统压缩/解压缩的性能。

从实际应用来说,硬件压缩的优劣主要从以下三方面来衡量:算法复杂度、压缩速度、压缩比。对于高性能VTL设备,需要它所采用的压缩算法复杂度较低,以降低实现成本,同时压缩速度和压缩比越高越好。 Hifn公司DR系列硬件压缩卡,采用公司独有的压缩芯片。该芯片使用公司拥有专利的LZS无损压缩算法,相对于桌面用户耳熟能详的GZIP,RAR等压缩算法,该算法具有算法复杂度更低、压缩解压缩性能优异、压缩比适中、以及独有的反容量膨胀(Anti-Expansion)技术等优势。正是由于上述优势,该算法已被广泛深入地应用于网络和存储各个领域,并被ANSI,IETF,ATM论坛,Frame Relay论坛等国际标准组织和技术联盟采纳为业界标准的一部分。

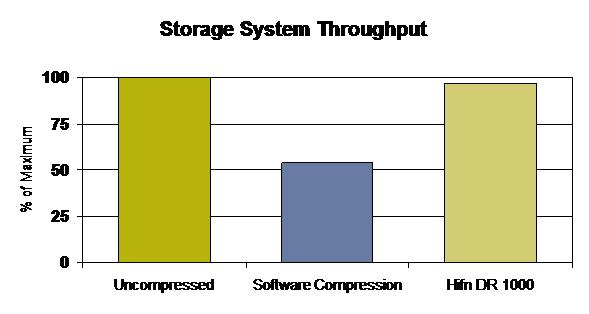

数据来源: 汉帆客户使用第三方ISV存储软件实测所得

这里将特定测试平台下未采用压缩功能时VTL系统的备份速度归一化为100%,在同样的硬件配置下,增加软件压缩功能之后,整个系统的备份速度下降到原来的54%,也即备份速度减慢了46%。 如果采用Hifn公司DR1000硬件压缩加速卡,将压缩部分的运算转交专门硬件压缩加速卡,整个系统的备份速度迅速恢复到未采用压缩时的97%,相对于软件压缩,采用硬件压缩加速卡之后存储系统备份的速度提升了80%。相对于未使用压缩功能,系统备份的性能降低仅有3%,对VTL系统的备份速度影响甚微。同时经过压缩之后,存储和传输中的数据会显著缩小,存储介质和网络带宽的利用率因此提高。数据的减少不仅使存储的效率更高、成本更节约,带宽的利用也降到最低,使更经济、更快速的实现备份数据的远程复制成为可能。

重复数据删除

数据压缩的对象是备份数据流,也就是在备份数据的字节流中查找重复出现的子串,重复子串出现后,仅记录原子串的位置和重复的长度。而重复数据删除的对象是文件或数据块,判断新的备份文件或数据块是否已经出现,如果已经备份过,则仅记录原文件或数据块存储的位置和大小。

早期受限于VTL系统主机CPU的处理能力,重复数据删除采用的是基于文件的形式,主要应用于电子邮件管理及归档系统。随着处理器性能的提升,以及类似于Hifn DR250/DR255这样的专门加速卡的出现,重复数据删除的对象逐渐转为数据块。

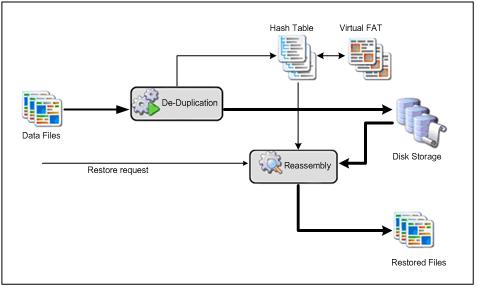

对于块级重复数据删除,当读取数据时,De-duplication引擎利用Hash算法识别唯一的数据块,系统将保留Hash索引,每个Hash编码指向一个不同的数据块。当新的备份发生时,会自动的与现有的块进行比对,如果索引中已经有相同的块,数据将会被删除或被指向块的指针所代替;反之,则会被保存并在索引中为其创建一个新的Hash编码。

衡量重复数据删除功能的优劣主要是重复数据删除比率,该参数与所用数据块的大小也即颗粒精细程度相关。理论上讲,更细致的颗粒会带来更高的重复数据删除比率。然而,更细致的颗粒意味着大量的Hash表,从而对De-duplication引擎的性能还有恢复时重组模块造成繁重的负担,进而导致更糟糕的重复数据删除性能和更高的CPU消耗。根据用户业务数据的不同,需要选用不同的颗粒尺寸,业内数据块的平均大小在4KB-24KB之间。在这种颗粒范围内,比较合理重复数据删除比率在10~20:1之间,实际应用时的重复数据删除比率随不同的业务数据会有所出入。

由于数据压缩和重复数据删除操作的对象属于备份数据流的不同级别,前者针对字节流,而后者针对数据块。因此可以将两种技术有效地结合起来,备份数据流可以先经过De-Duplication执行去重操作,再将唯一的数据块送入硬件压缩加速卡压缩。经这两步处理之后,需要存储的数据总量可能只有原始数据的2.5%~5%之间。

Hifn公司作为全球领先的容量优化技术的硬件加速方案提供商,其旗下数据压缩工业标准专利算法和Express DR系列产品线,为OEM和系统集成商提供了完善的解决方案。其中Express DR1000加速卡提供了业界最强的压缩处理能力,高达800 MB/s。Express DR250/255加速卡在提供数据压缩加速的同时,还具有对重复数据删除技术提供加速的能力,支持MD5、SHA-1等主要安全Hash算法,处理性能达到250MB/s。

硬件压缩和重复数据删除,这两种容量优化技术可以有效地缩小备份数据对物理存储介质的消耗,提升系统的可靠性,显著降低数据中心空间、供电和冷却成本。对于构建新一代节能环保,更绿色的数据中心,具有非常重要的意义。