ocp考试资料群:569933648 验证码:ocp OCP 12c 19c考试题库解析与资料群:钉钉群号:35277291

全部博文(488)

分类: LINUX

2025-03-05 15:40:55

简单测试了一下在linux上搭建本地deepseek,需要用到:linux、ollama、chatboxai

1、 下载安装ollama ollama 是一款开源应用,可让你在 Windows、MacOS 和 Linux 上使用命令行界面在本地运行、创建和共享大型语言模型。

网址:

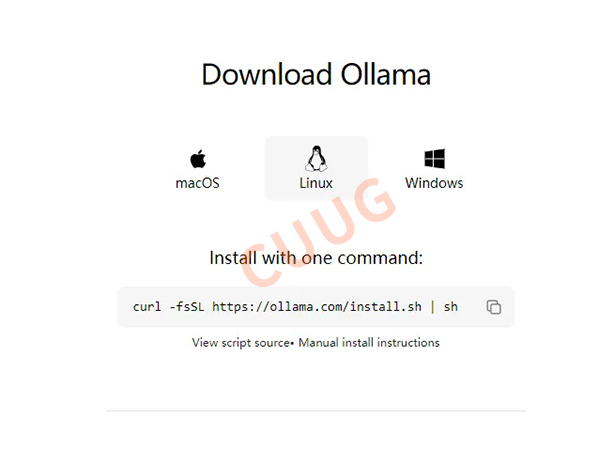

1.1、 首页找到下载【Download】-【Linux】

1.2、 在linux下执行命令

curl -fsSL /install.sh | sh

安装完成,可以输入 ollama --version 来检验是否安装成功,如果正确安装则会输出所安装 ollama 的版本号。

如果安装过程中出现警告信息,可根据提示安装需要的安装包、或者给运行需要的权限等方法解决。

2、 下载安装deepseek模型

同样在ollama的网站,在导航上找到【Models】,选择【deepseek-r1】模型,选择【1.5b】做测试,表示该模型有 15 亿个参数。

3、 下载并执行deepseek模型

ollama run deepseek-r1:1.5b

1.5b有1.1个G大小,需要下载一段时间,也可以把命令中的“run”换成“pull”,支持断点续传。

如果看到 success 字样也就说明模型下载完成了,执行命令ollama list可查看 ollama 目前所下载的模型列表。

4、 下载chatbox:

Chatbox AI 是一款 AI 客户端应用和智能助手,支持众多先进的 AI 模型和 API,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用。 地址:

可以选择下载客户端到本地,或者直接在网页上访问,如果是本地大模型部署,选择前者。

5、 配置环境变量

在linux服务器端配置ollama服务。

5.1、修改/etc/systemd/system/ollama.service.d/override.conf文件

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

#ExecStart=/usr/local/bin/ollama serve #屏蔽掉此行

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="PATH=/usr/local/mysql8.0.30/bin:/home/gptt/myvenv/bin:/home/gptt/.local/bin:/home/gptt/anaconda3/bin:/home/gptt/anacond" #这个自动获取

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"

5.2、重启ollama服务

systemctl daemon-reload

systemctl restart ollama.service

systemctl status ollama.service

查看端口状态,默认监听11434端口:

ss -tulnp

6、 配置chatbox

如果模型一开始不能显示,可以配置到第3步时先保存再设置就可以看到了,因为只有连接到本地大模型后才可以显示。

7、 开始对话

本次服务器配置比较简单,cpu为4核,内存8g,无gpu,在回答时有点滞后,但是还是可以接受的。

8、 相关网址

linux下搭建本地deepseek.docx

链接:

提取码: jwgk

ollama:

chatboxai: